死锁定义

线程死锁是指由于两个或者多个线程互相持有对方所需要的资源,导致这些线程处于等待状态,无法前往执行。

必要条件

互斥:每个资源要么已经分配给了一个进程,要么就是可用的。

占有和等待:已经得到了某个资源的进程可以再请求新的资源。

不可抢占:已经分配给一个进程的资源不能强制性地被抢占,它只能被占有它的进程显式地释放。

环路等待:有两个或者两个以上的进程组成一条环路,该环路中的每个进程都在等待下一个进程所占有的资源。

死锁的处理策略

鸵鸟策略

把头埋在沙子里,假装根本没发生问题。

因为解决死锁问题的代价很高,因此鸵鸟策略这种不采取任务措施的方案会获得更高的性能。

当发生死锁时不会对用户造成多大影响,或发生死锁的概率很低,可以采用鸵鸟策略。

大多数操作系统,包括 Unix,Linux 和 Windows,处理死锁问题的办法仅仅是忽略它。

死锁预防:破坏死锁的四个条件之一

破环互斥条件:允许资源共享;

破环占有和等待条件:一次性分配所有资源,只要缺少一个资源,其它资源也都不给他分配;

破坏不可抢占:请求新资源得不到时,释放已经保持占有的资源,待以后重新申请;

破坏环路等待:采用顺序资源分配法,给每个资源编号,进程申请资源的时候按照编号顺序申请,释放的时候则相反;

死锁检测与解除:

检测死锁:利用死锁原理化简资源分配图检测死锁的存在

死锁解除:资源剥夺、撤销进程、进程回退

剥夺资源:从其它进程剥夺足够数量的资源给死锁进程,以解除死锁状态; 撤消进程:可以直接撤消死锁进程或撤消代价最小的进程,直至有足够的资源可用,死锁状态.消除为止;所谓代价是指优先级、运行代价、进程的重要性和价值等。死锁避免:死锁避免事先预防策略,但是是采用资源动态分配的过程中,防止系统进入不安全状态,以避免死锁。

预防死锁的几种策略,会严重地损害系统性能。因此在避免死锁时,要施加较弱的限制,从而获得 较满意的系统性能。由于在避免死锁的策略中,允许进程动态地申请资源。因而,系统在进行资源分配之前预先计算资源分配的安全性。若此次分配不会导致系统进入不安全的状态,则将资源分配给进程;否则,进程等待。其中最具有代表性的避免死锁算法是银行家算法。

银行家算法:首先需要定义状态和安全状态的概念。系统的状态是当前给进程分配的资源情况。因此,状态包含两个向量Resource(系统中每种资源的总量)和Available(未分配给进程的每种资源的总量)及两个矩阵Claim(表示进程对资源的需求)和Allocation(表示当前分配给进程的资源)。安全状态是指至少有一个资源分配序列不会导致死锁。当进程请求一组资源时,假设同意该请求,从而改变了系统的状态,然后确定其结果是否还处于安全状态。如果是,同意这个请求;如果不是,阻塞该进程知道同意该请求后系统状态仍然是安全的。

银行家算法

银行家算法是仿照银行发放贷款时采用的控制方式而设计的一种死锁避免算法,该算法的策略是实现动态避免死锁。

算法思想

银行家算法的基本思想是:分配资源之前,判断系统是否安全,如果安全才会进行资源分配。

我们把操作系统看做是银行家,操作系统管理的资源相当于银行家的资金,线程向操作系统请求分配资源就是用户向银行家要贷款。

算法在每次分配资源前需要要求: request < available && request < needing;

算法实例

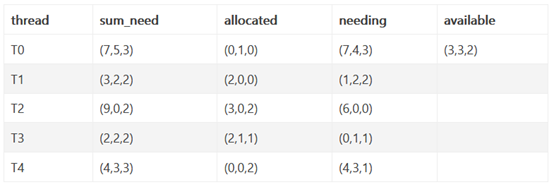

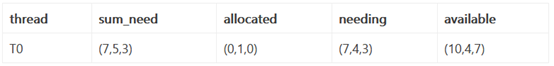

系统中有R1,R2,R3三种资源,在time0时刻,5个线程T0,T1,T2,T3,T4对资源占用和需求的情况如下表,此时系统的可用资源向量为(3,3,2)。求T0时刻系统是否存在安全序列?

我们假设每个线程执行时间为一个时刻。

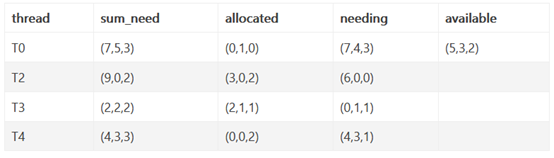

1、在time0时刻,available(3,3,2) > T1.needing(1,2,2); 所以T1可以执行,T1执行完毕之后available = T1.allocated(2,0,0) + available(3,3,2) = (5,3,2);

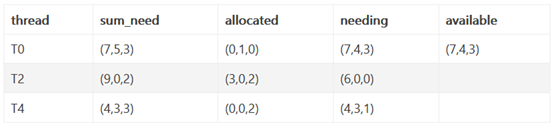

2、进入time1时刻,available(5,3,2) > T3.needing(0,1,1);所以T3可以执行,T3执行完毕之后available = T3.allocated(2,1,1)+available(5,3,2) = (7,4,3);

3、进入time2时刻,available(7,4,3) > T4.needing(4,3,1);所以T4可以执行,T4执行完毕之后available = T4.allocated(0,0,2) + available(7,4,3) = (7,4,5);

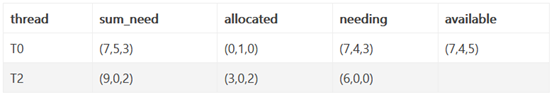

4、进入time3时刻,available(7,4,5) > T2.needing(6,0,0);所以T2可以执行,T2指向完毕之后available = T2.allocated(3,0,2) + available(7,4,5) = (10,4,7);

5、进入time4时刻,因为available(10,4,7) > T0.needing(7,4,3);所以执行T0。完成安全序列。

上面只是安全序列的一个例子,可能还存在其他安全序列。